本文最后更新于 478 天前,其中的信息可能已经有所发展或是发生改变。

参考资料:文章内容主要来自吴恩达老师的机器学习课程及周志华老师的《机器学习》,李航老师的《统计学习方法》

参考视频:2.3 感知机——学习算法之对偶形式:算法解说_哔哩哔哩_bilibili

梯度下降

原理

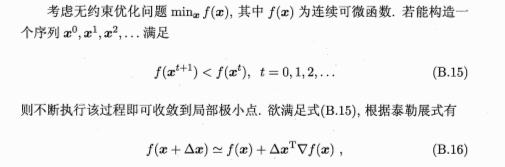

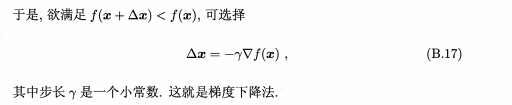

梯度下降法(gradient descent)是一种常用的一阶(first-order)优化方法,是 求解无约束优化问题最简单,最经典的方法之一,常用于求解模型参数

原理举例:

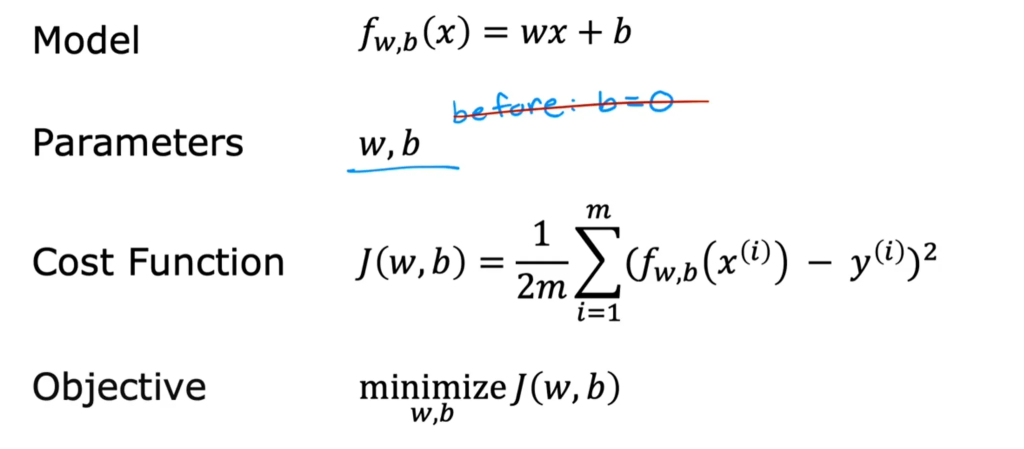

以求解一元线性回归问题y=wx+b的最佳拟合参数a和b为例

此时求最佳模型参数的过程可理解为 求二元函数因变量(误差大小)取最小值时的两个自变量(w,b)的值

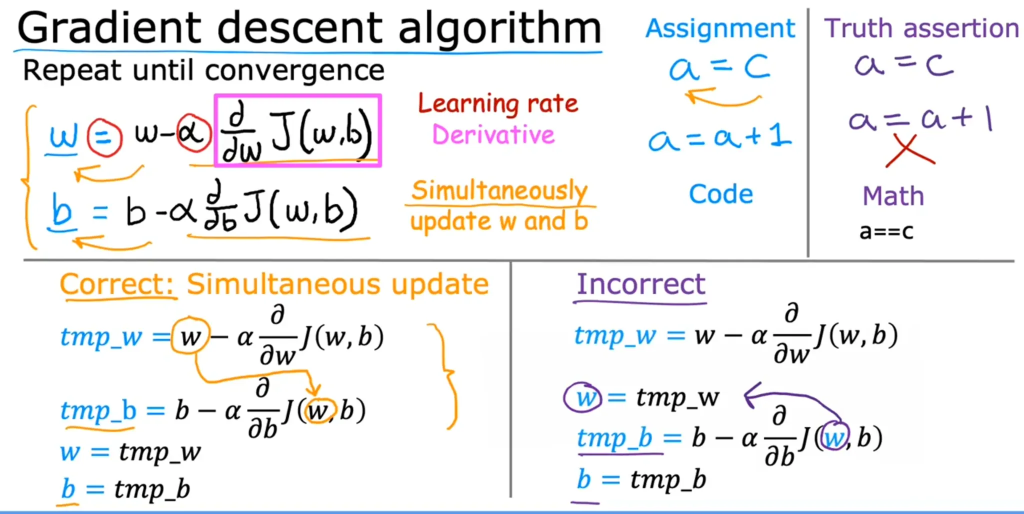

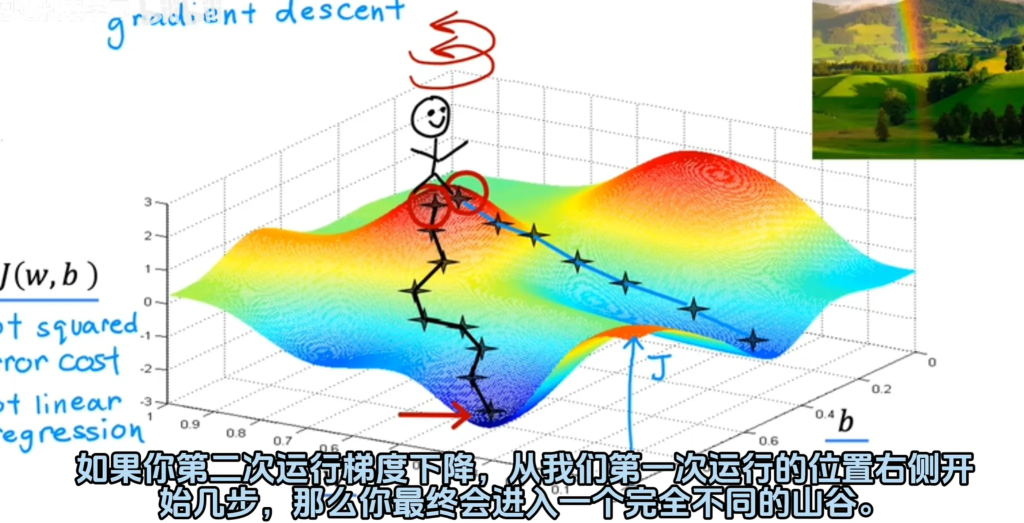

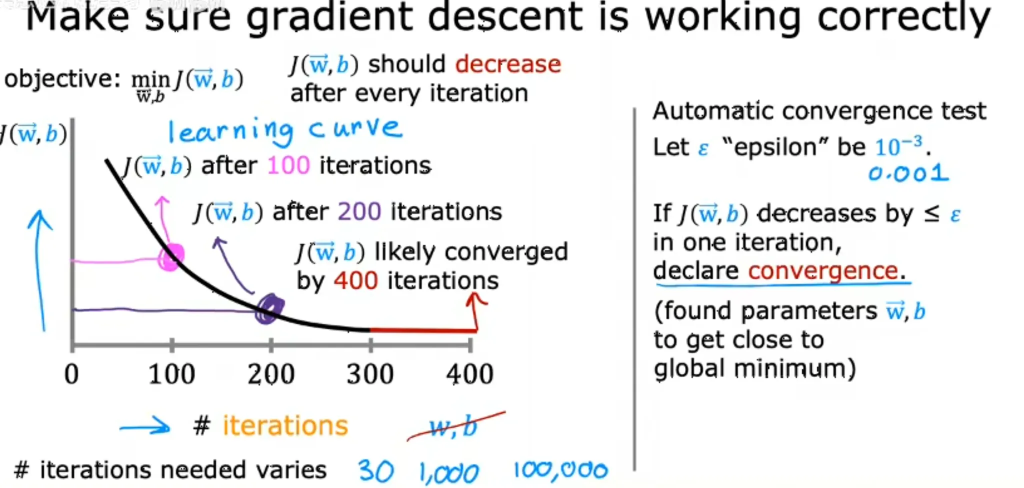

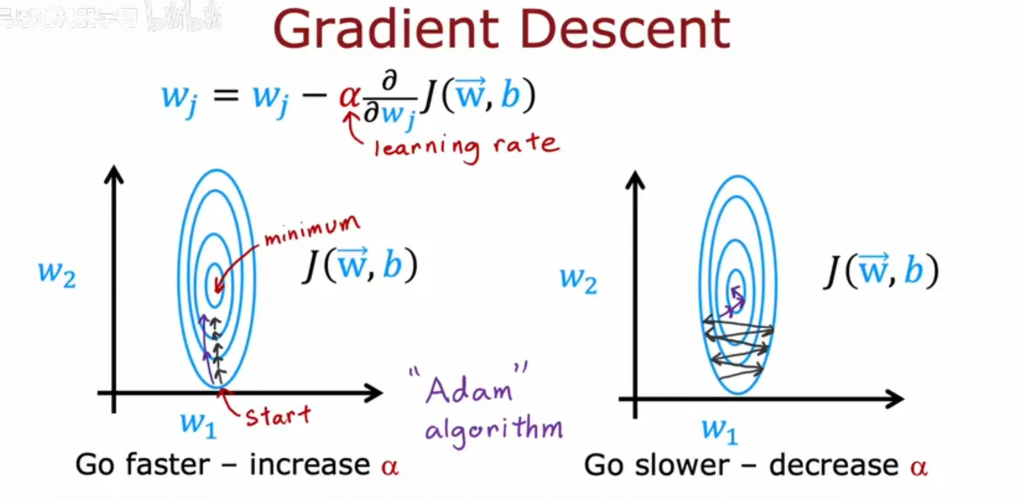

将参数减去步长×该参数对应的偏导数,并不断循环这一过程,使参数不断趋近于导数方向,最终得到局部最小值,若函数为凸函数即位函数的最小值。

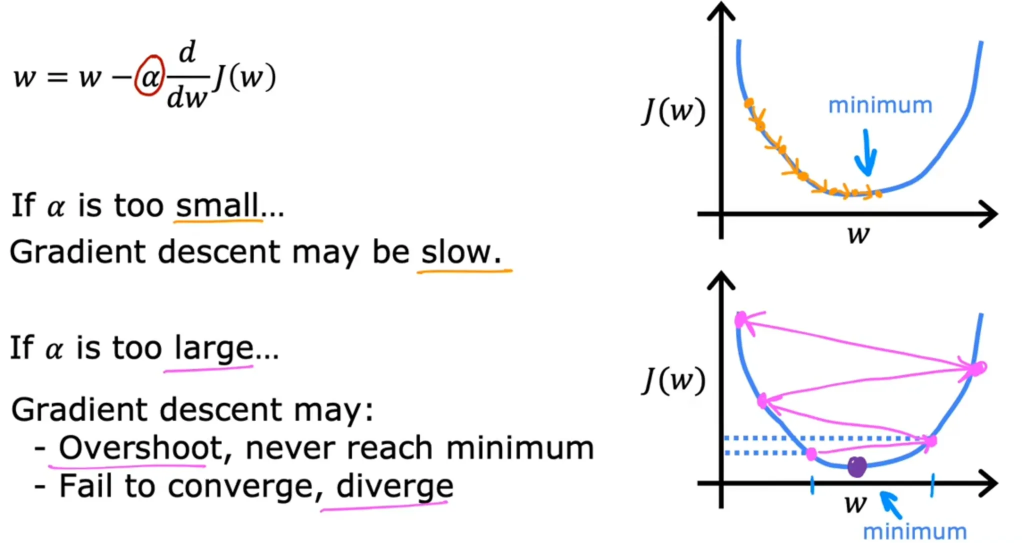

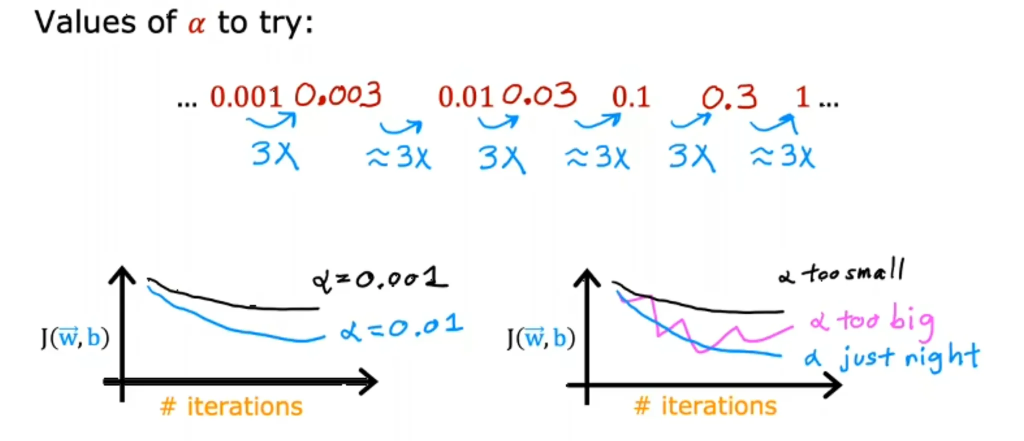

步长大小如何选择?

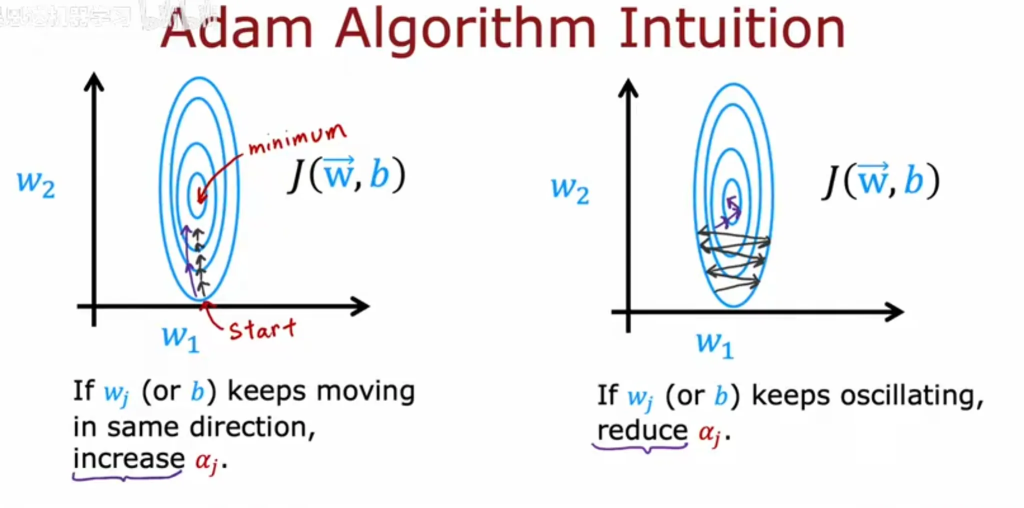

梯度下降的优化方法

感知机模型

感知机原理

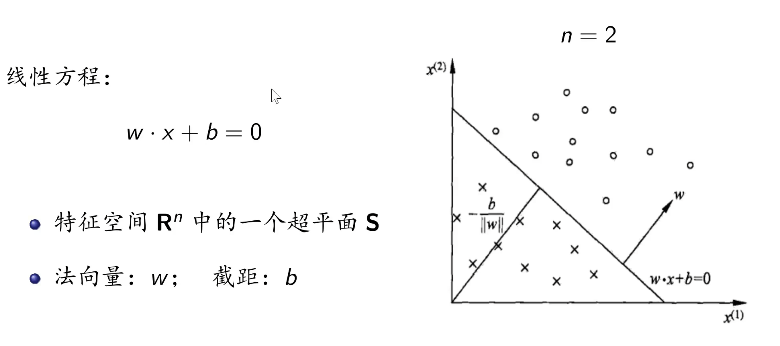

基础:一般来说n维空间可被n-1维超平面分离

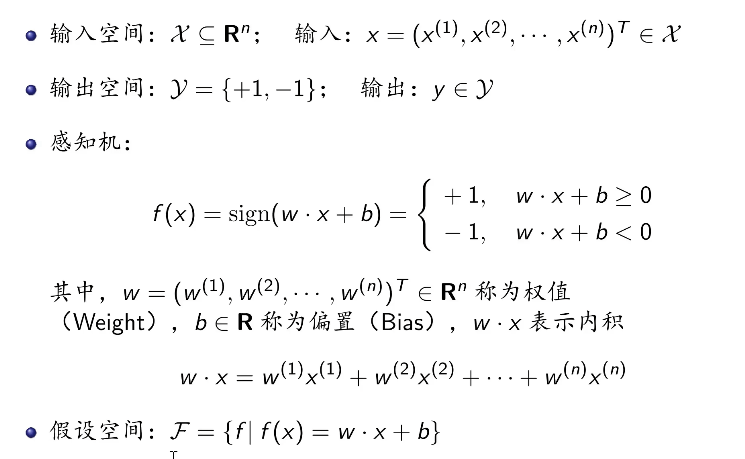

感知机表达式

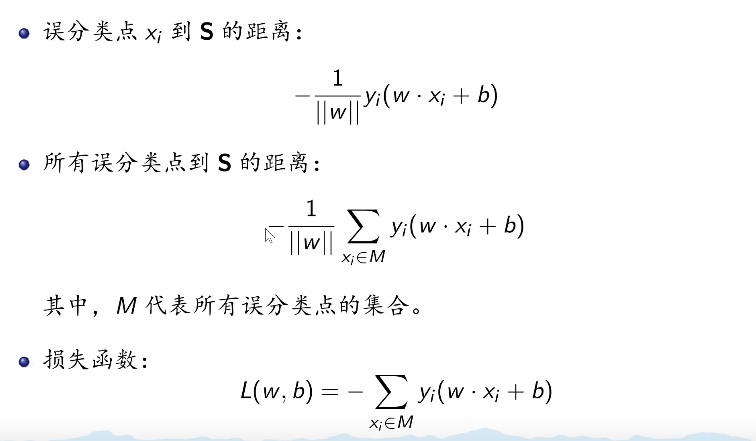

感知机的损失函数

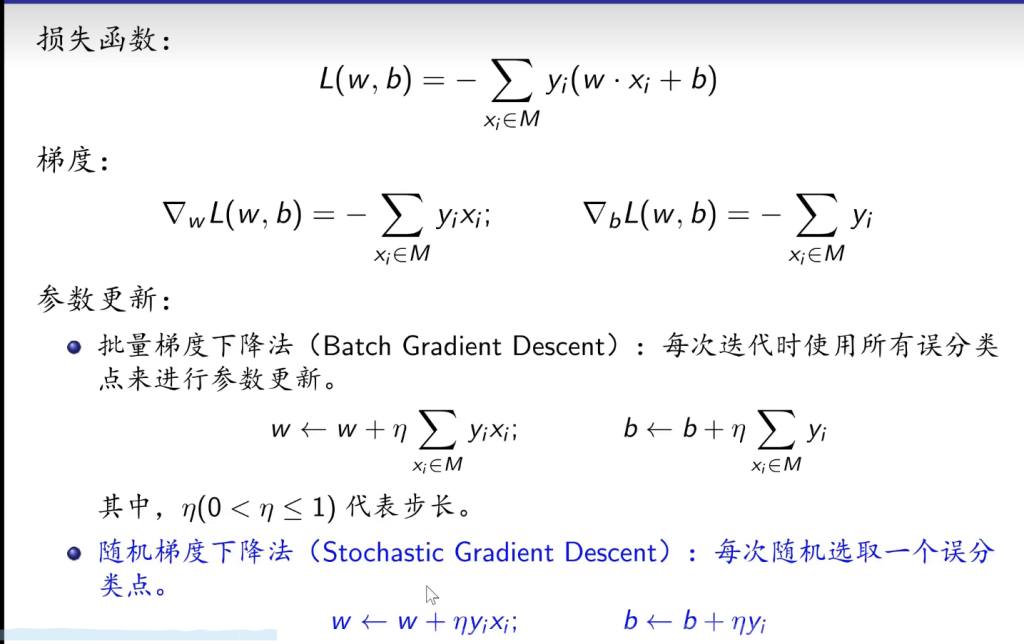

随机梯度下降法(提高运算时间)

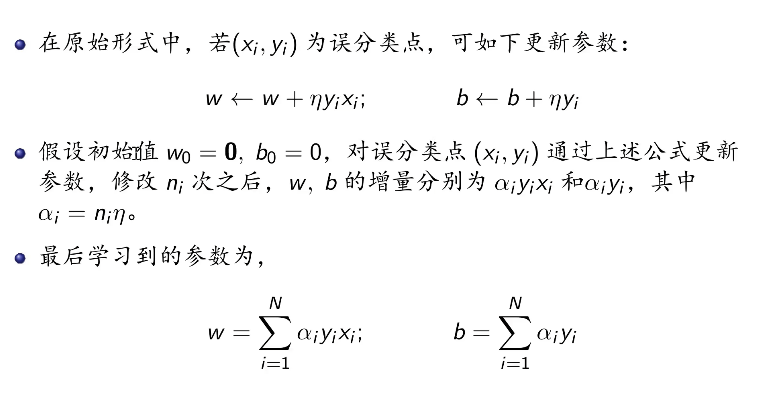

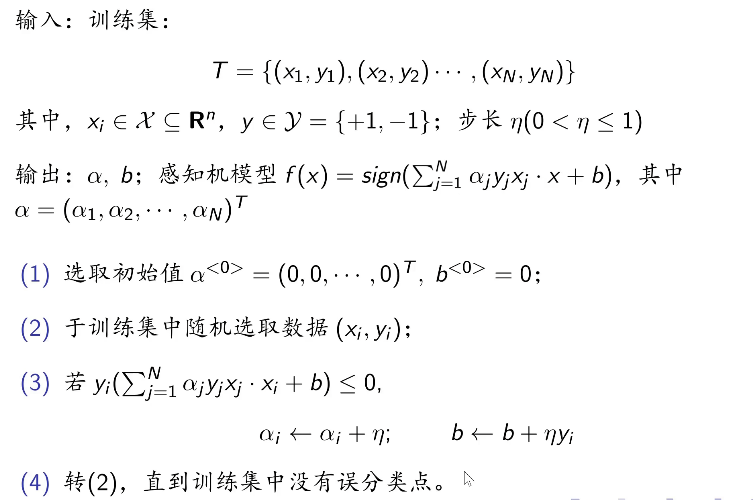

对偶形式

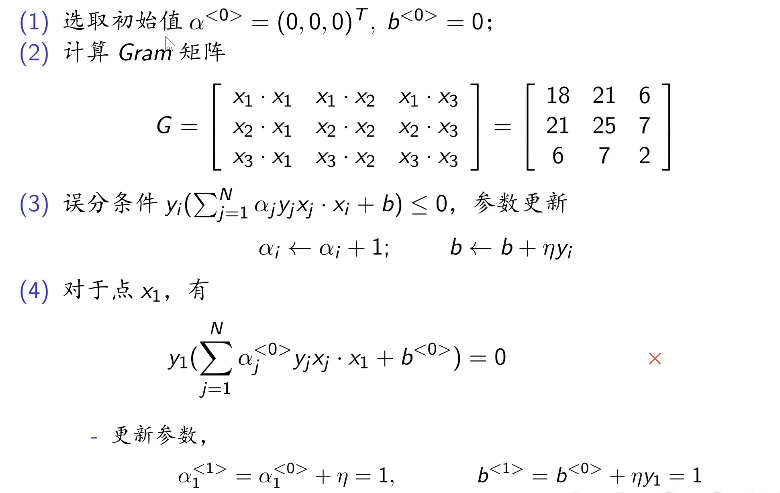

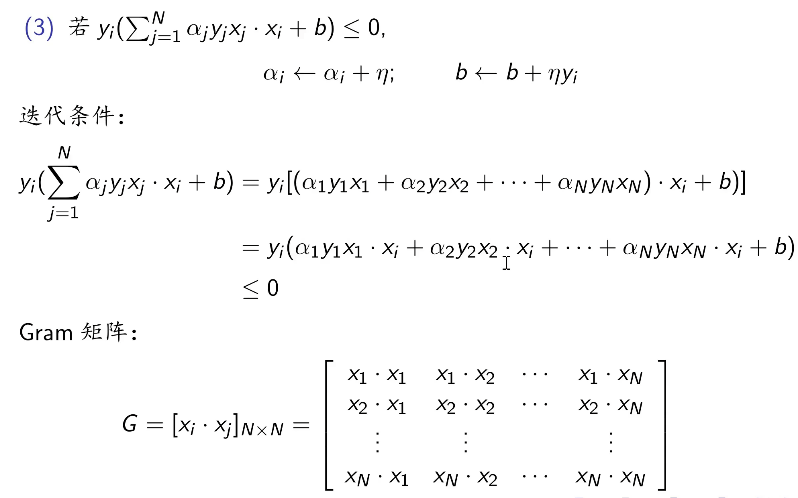

详解第三步

Gram矩阵使后续计算方便

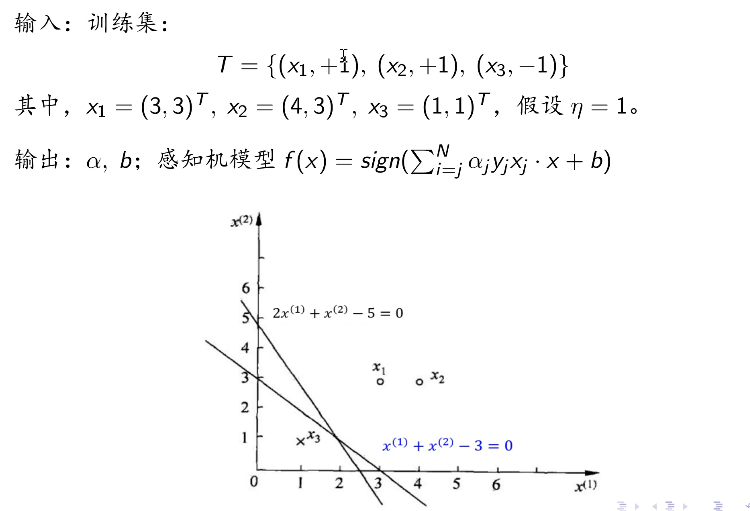

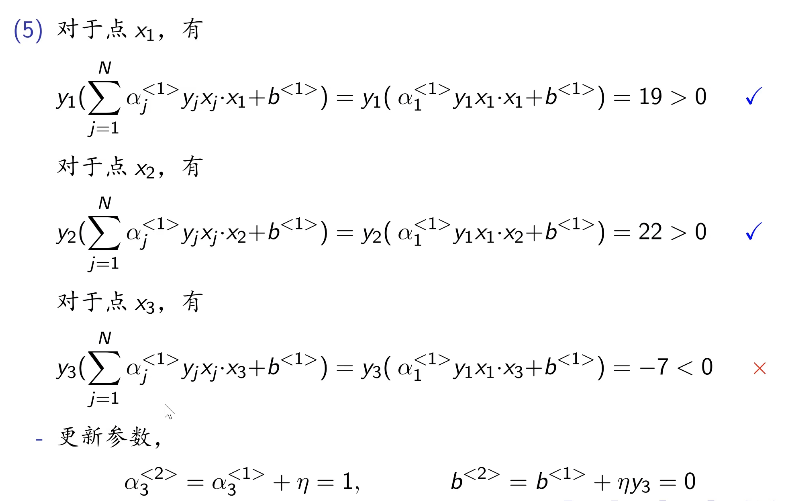

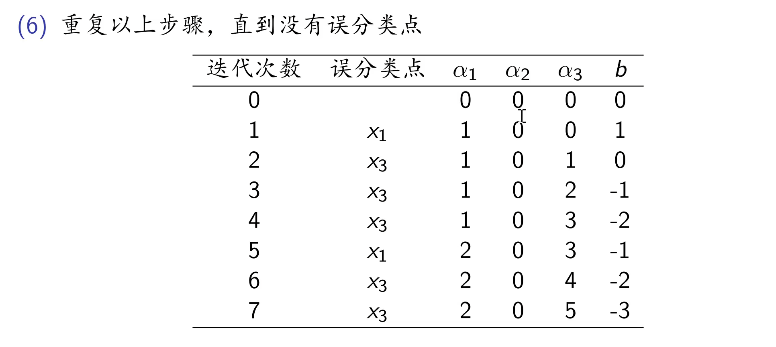

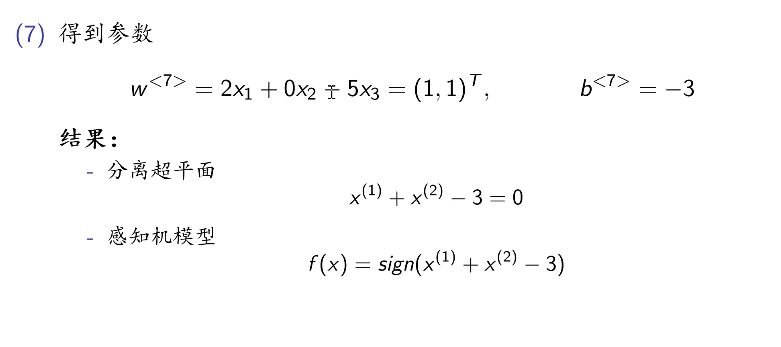

对偶计算举例